在网络爬虫的世界中,使用代理IP是一项关键的技术,可以提高爬虫的效率、降低被封禁的风险,并实现更广泛的数据采集。本文将深入探讨如何有效地使用代理IP进行网络爬虫,解决反爬虫机制带来的挑战,提高数据获取的成功率。

1. 代理IP的基础知识

代理IP作为网络爬虫领域的一项关键技术,具有许多重要的基础知识,它是实现爬虫隐匿性、提高稳定性和绕过反爬虫机制的重要工具。在本节中,我们将深入了解代理IP的基本概念以及它在网络爬虫中的作用。

1.1 代理IP的定义与作用

代理IP指的是位于互联网上的一台中间服务器,它充当了爬虫与目标服务器之间的中介角色。通过使用代理IP,爬虫可以隐藏真实的IP地址,使得对目标服务器的请求看起来是来自代理服务器而非爬虫本身。这种方式带来了以下几个主要的作用:

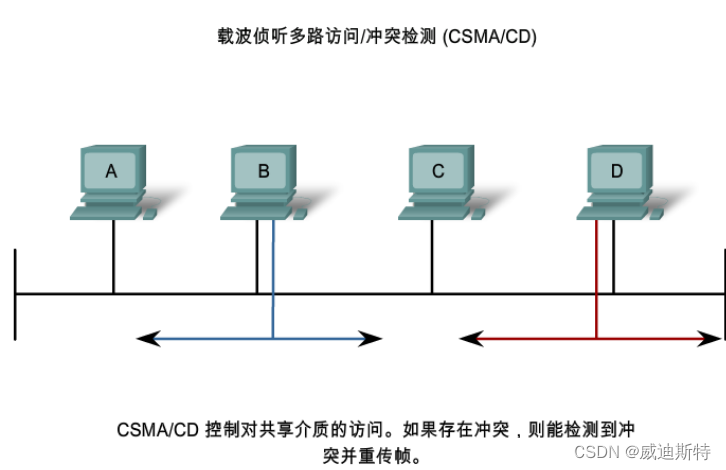

1. 隐藏真实IP地址: 通过使用代理IP,爬虫可以隐藏其真实的IP地址,增强匿名性,防止被目标服务器追踪。

2. 分散请求: 代理IP允许爬虫通过多个不同的IP地址发送请求,有效地分散了请求负载,降低了单个IP的请求频率,减轻了对目标服务器的压力。

3. 绕过访问限制: 有些网站对特定IP或IP段进行了访问限制,使用代理IP可以帮助爬虫绕过这些限制,获取被封锁的内容。

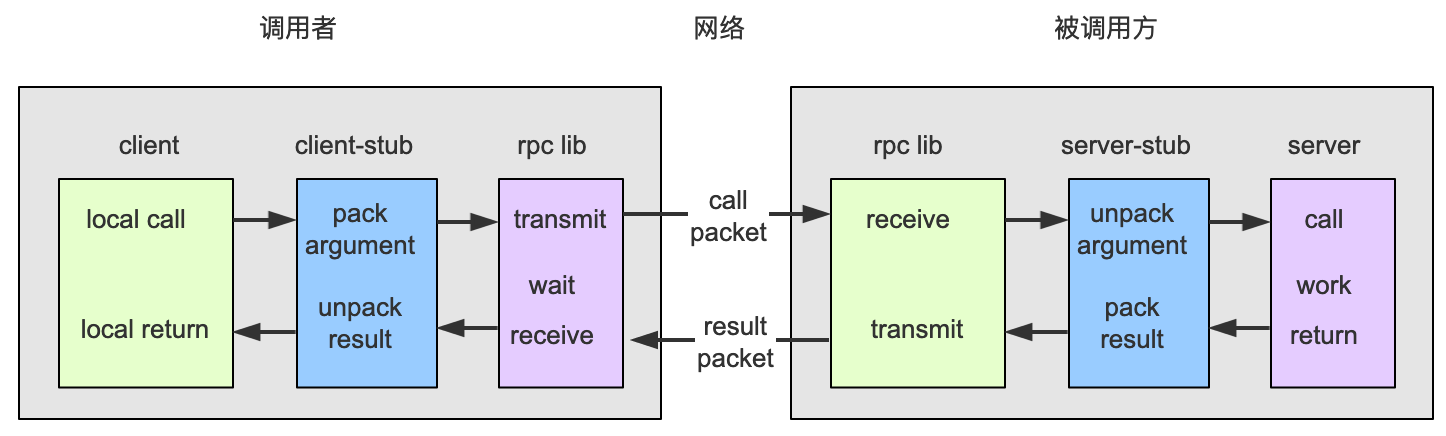

1.2 代理IP的工作原理

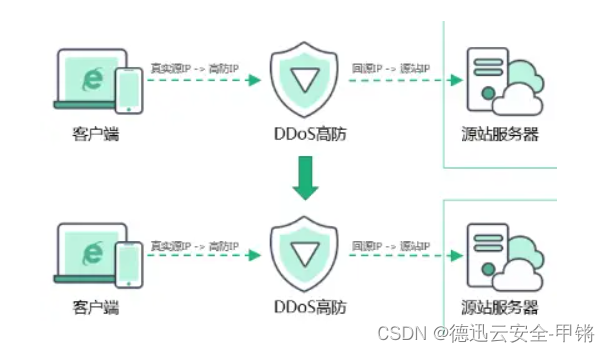

代理IP的工作原理涉及到爬虫、代理服务器和目标服务器之间的协同作用。在使用代理IP的过程中,爬虫发送HTTP请求不再直接到达目标服务器,而是先经过代理服务器,再由代理服务器向目标服务器发起请求。

具体工作流程如下:

- 爬虫通过代码设置代理IP,包括代理IP的地址和端口信息。

- 爬虫发送HTTP请求时,请求首先被发送到代理服务器。

- 代理服务器接收请求后,将请求再次发送到目标服务器。

- 目标服务器响应代理服务器的请求,代理服务器再将响应返回给爬虫。

这个过程中,目标服务器只能看到代理服务器的IP地址,而无法获取到爬虫真实的IP地址。这种中间层的存在使得代理IP成为维护爬虫隐匿性的关键因素。

1.3 代理IP的分类

代理IP可以根据其匿名性和使用方式进行分类。以下是一些常见的代理IP分类:

1. 透明代理: 不隐藏真实IP,仅用于访问控制。

2. 匿名代理: 隐藏了真实IP,但仍然向目标服务器透露了自己是代理。

3. 高匿代理(Elite代理): 完全隐藏了真实IP,目标服务器无法识别请求是通过代理发送的。

4. 公共代理: 免费提供的代理IP,通常稳定性较差,适用于简单任务。

5. 私密代理: 通过购买或租用的代理IP,通常提供更稳定和高质量的服务。

1.4 代理IP的使用注意事项

在使用代理IP时,需要注意一些重要的事项,以确保爬虫活动的合法性和可持续性:

1. 遵守网站规则: 爬虫应遵循目标网站的使用规则,不得进行违法或滥用的活动。

2. 谨慎选择代理IP: 选择稳定、高匿名性的代理IP,避免使用可能引起目标服务器注意的公共代理。

3. 代理IP的定期更换: 定期更换代理IP,防止被目标服务器封禁。

4. 避免过于频繁的请求: 控制爬虫请求的频率,避免对目标服务器造成过大的负载。

5. 处理代理IP的异常情况: 实现异常处理机制,及时处理代理IP失效或被封禁的情况。

通过理解代理IP的基础知识,爬虫可以更好地利用这一技术来提高自身的匿名性、稳定性,并有效地绕过一些反爬虫机制,实现更为顺畅的数据采集。接下来,我们将深入探讨如何获取可用的代理IP。

2. 如何获取代理IP

获取可用的代理IP是使用代理的第一步。我们可以通过免费代理IP网站或付费代理IP服务提供商获取IP地址。给大家推荐一款不错的代理IP服务提供商:品易HTTP。在代码中,我们可以使用请求库(例如Requests)来发送HTTP请求,获取代理IP列表。

2.1 选择代理IP来源

免费的代理IP网站通常提供公开的代理IP,但其稳定性和匿名性可能相对较低。付费的代理IP服务提供商则提供更为稳定和高质量的代理IP,适用于一些对稳定性要求较高的任务。

2.2 使用Requests库获取代理IP页面

import requests

url = 'https://free-proxy-list.net/'

response = requests.get(url)

# 检查请求是否成功

if response.status_code == 200:

print('Successfully fetched proxy IP page')

else:

print('Failed to fetch proxy IP page')

在这个示例中,我们使用Requests库发送GET请求到免费代理IP网站,检查返回的状态码以确保成功获取页面。

2.3 使用解析库提取代理IP信息

获取代理IP页面后,我们需要使用解析库来解析HTML并提取代理IP信息。常用的解析库包括Beautiful Soup和lxml。

from bs4 import BeautifulSoup

# 使用Beautiful Soup解析页面

soup = BeautifulSoup(response.text, 'html.parser')

# 在这里插入提取代理IP信息的代码

在这个阶段,我们可以通过Beautiful Soup提供的功能,定位HTML中包含代理IP信息的元素,并提取出所需的数据。

2.4 提取代理IP信息的代码示例

# 假设代理IP信息在一个表格中,表格的class为'proxy-table'

proxy_table = soup.find('table', {'class': 'proxy-table'})

# 提取每行的代理IP和端口信息

proxy_list = []

for row in proxy_table.find_all('tr')[1:]: # 跳过表头

columns = row.find_all('td')

ip = columns[0].text

port = columns[1].text

proxy = f'{ip}:{port}'

proxy_list.append(proxy)

print('List of extracted proxy IPs:')

print(proxy_list)

在这个示例中,我们假设代理IP信息在一个表格中,通过Beautiful Soup找到表格并提取每行的代理IP和端口信息。最终,我们得到一个包含代理IP的列表。

通过这个过程,我们成功获取了代理IP页面并提取了代理IP信息。在实际使用中,爬虫开发者可以根据实际情况调整解析代码,以适应不同的代理IP页面结构。接下来,我们将深入讨论如何使用代理IP发送请求。

通过这个过程,我们成功获取了代理IP页面并提取了代理IP信息。在实际使用中,爬虫开发者可以根据实际情况调整解析代码,以适应不同的代理IP页面结构。接下来,我们将深入讨论如何使用代理IP发送请求。

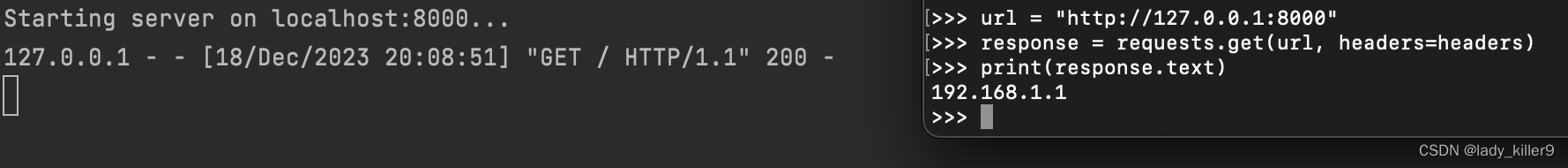

3. 使用代理IP发送请求

在网络爬虫中,使用代理IP发送请求是一项关键的技术,它帮助爬虫隐藏真实IP、提高匿名性,并有效应对目标服务器的限制。以下是如何使用代理IP发送请求的详细步骤:

3.1 设置代理IP

在开始发送请求之前,需要设置代理IP。代理IP是一个包含HTTP和HTTPS代理地址及端口的字典。

# 设置代理IP

proxy = {'http': 'http://proxy_ip:proxy_port', 'https': 'https://proxy_ip:proxy_port'}

在这个示例中,我们定义了一个字典形式的代理IP,包括HTTP和HTTPS两种协议,分别对应代理IP的地址和端口。

3.2 发送带有代理的请求

设置好代理IP后,可以使用Requests库发送HTTP请求,并在请求中添加proxies参数,将代理IP传递给Requests。

# 发送带有代理的请求

response = requests.get('https://target_website.com', proxies=proxy)

在这个示例中,我们向目标网站发送了一个GET请求,并指定了代理IP。Requests库会在发送请求时使用指定的代理IP,而不是直接连接目标服务器。

3.3 处理响应

成功发送请求后,需要处理响应。具体的处理方式取决于爬虫的需求和目标网站的结构,可能包括解析HTML、提取信息等操作。

# 处理响应

# (在这里插入处理响应的代码)

在这个部分,根据目标网站的特点,可能需要使用解析库(如Beautiful Soup)对返回的HTML进行解析,并提取出所需的信息。

4. 处理代理IP的异常和失效

代理IP并非永远可靠,有时会出现连接超时、失效或被封禁的情况。为了应对这些异常,我们需要实现一些异常处理机制,以确保爬虫的鲁棒性。

import requests

def get_response_with_proxy(url, proxy):

try:

response = requests.get(url, proxies=proxy, timeout=5)

response.raise_for_status() # 检查请求是否成功

return response

except requests.exceptions.RequestException as e:

print(f"Error: {e}")

return None

5. 代理IP的轮换和池化

为了提高爬虫的稳定性和匿名性,代理IP的轮换和池化是一种常见的策略。轮换是指定期更换使用的代理IP,而池化是维护多个代理IP,根据需要随机选择一个使用。以下是如何实现代理IP的轮换和池化的详细步骤:

5.1 代理IP的轮换

轮换代理IP的目的是防止单个代理IP被频繁使用而被封禁,同时提高匿名性。可以通过定期更换使用的代理IP来实现轮换。

import random

import time

def rotate_proxy(pool):

# 随机选择一个代理IP

selected_proxy = random.choice(pool)

print(f'Selected Proxy: {selected_proxy}')

# 模拟使用代理IP的操作

response = get_response_with_proxy('https://target_website.com', selected_proxy)

# 处理响应

# (在这里插入处理响应的代码)

# 可选:休眠一段时间,模拟轮换周期

time.sleep(60) # 休眠60秒

在这个示例中,我们通过random.choice()随机选择一个代理IP,并模拟使用该代理IP发送请求。在实际应用中,轮换周期可以根据需求进行调整。

5.2 代理IP的池化

代理IP的池化是维护多个代理IP,并根据需要随机选择一个使用。通过这种方式,可以实现更灵活和多样化的代理IP使用策略。

import random

# 定义代理IP池

proxy_pool = [

{'http': 'http://proxy1_ip:proxy1_port', 'https': 'https://proxy1_ip:proxy1_port'},

{'http': 'http://proxy2_ip:proxy2_port', 'https': 'https://proxy2_ip:proxy2_port'},

# 添加更多代理IP

]

# 随机选择一个代理IP

selected_proxy = random.choice(proxy_pool)

response = get_response_with_proxy('https://target_website.com', selected_proxy)

在这个示例中,我们定义了一个代理IP池proxy_pool,其中包含多个代理IP的字典。通过random.choice()随机选择一个代理IP,然后使用该代理IP发送请求。

6. 如何测试代理IP的可用性

在使用代理IP之前,最好先测试其可用性,以确保代理IP能够成功发送请求并获取响应。以下是如何测试代理IP可用性的详细步骤:

6.1 编写代理IP测试函数

我们可以编写一个函数,接收代理IP作为参数,向目标服务器发送测试请求,并根据响应结果判断代理IP是否有效。

import requests

def test_proxy(proxy):

test_url = 'https://test_target_website.com'

response = get_response_with_proxy(test_url, proxy)

if response is not None:

print("Proxy is working!")

else:

print("Proxy is not working. Removing from pool.")

# 从代理池中移除失效的代理IP

# (在这里插入代码)

在这个示例中,test_proxy函数接收一个代理IP作为参数,使用该代理IP发送测试请求。如果成功获取到响应,表示代理IP有效;否则,表示代理IP失效,可能需要从代理IP池中移除。

6.2 调用代理IP测试函数

在使用代理IP之前,可以先调用测试函数,检查代理IP的可用性。

# 代理IP池

proxy_pool = [

{'http': 'http://proxy1_ip:proxy1_port', 'https': 'https://proxy1_ip:proxy1_port'},

{'http': 'http://proxy2_ip:proxy2_port', 'https': 'https://proxy2_ip:proxy2_port'},

# 添加更多代理IP

]

# 遍历代理IP池,测试每个代理IP的可用性

for proxy in proxy_pool:

test_proxy(proxy)

在这个示例中,我们遍历了代理IP池中的每个代理IP,并调用了test_proxy函数测试其可用性。根据测试结果,可以采取相应的措施,如将失效的代理IP从池中移除。

7. 反爬虫机制的绕过与注意事项

虽然代理IP可以有效绕过一些简单的反爬虫机制,但在实际爬虫实践中,需要谨慎处理一些更复杂的反爬虫手段。同时,保持良好的伦理和法规意识,遵守目标网站的使用政策是至关重要的。以下是关于反爬虫机制的绕过和注意事项:

7.1 绕过简单的反爬虫机制

代理IP可以有效地绕过一些简单的反爬虫机制,例如对单一IP频繁访问的限制。通过轮换和池化代理IP,爬虫可以降低被封禁的风险,提高成功率。

# 示例:轮换和池化代理IP

proxy_pool = [

{'http': 'http://proxy1_ip:proxy1_port', 'https': 'https://proxy1_ip:proxy1_port'},

{'http': 'http://proxy2_ip:proxy2_port', 'https': 'https://proxy2_ip:proxy2_port'},

# 添加更多代理IP

]

# 随机选择一个代理IP并发送请求

selected_proxy = random.choice(proxy_pool)

response = get_response_with_proxy('https://target_website.com', selected_proxy)

在这个示例中,通过随机选择代理IP并发送请求,爬虫可以规避一些对频繁访问的简单限制。

7.2 处理验证码和用户行为检测

一些网站采用更复杂的反爬虫手段,如验证码和用户行为检测。对于这类情况,爬虫可能需要实现一些更高级的解决方案,如使用自动识别验证码的工具、模拟用户行为等。

# 示例:使用自动识别验证码的工具

from captcha_solver import solve_captcha

# 获取包含验证码的页面

captcha_page = get_captcha_page('https://target_website.com/captcha')

# 自动识别验证码并获取结果

captcha_result = solve_captcha(captcha_page)

# 使用验证码结果发送请求

response = get_response_with_captcha('https://target_website.com', captcha_result)

在这个示例中,通过使用自动识别验证码的工具,爬虫可以获取验证码页面并自动识别验证码,然后使用识别结果发送请求。

7.3 注意伦理和法规意识

在进行网络爬虫时,必须保持良好的伦理和法规意识。遵守目标网站的使用政策,不进行滥用、侵犯隐私或违法的活动是非常重要的。避免对目标服务器造成过大的负载,控制爬虫的请求频率,以确保对目标网站的访问是合理且可接受的。

总结

通过学习本文,读者将获得关于如何高效使用代理IP进行网络爬虫的全面指南。这一技术不仅提高了爬虫的成功率,还加强了爬虫的匿名性和稳定性。在实际应用中,根据目标网站的特点和反爬虫策略,灵活选择和配置代理IP将成为网络爬虫任务中的重要一环。